關(guān)于遠(yuǎn)景保安 About Yuanjing Security Staff

陜西遠(yuǎn)景保安服務(wù)有限公司是依托2007年5月29日成立的陜西遠(yuǎn)景保安培訓(xùn)學(xué)校(2010年9月6日更名為陜西遠(yuǎn)景職業(yè)技能培訓(xùn)學(xué)校)于2010年4月12日相繼成立。

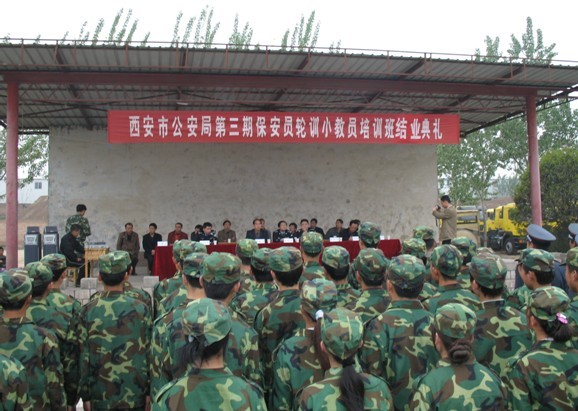

是經(jīng)西安市公安局審查,陜西省公安廳、陜西省民政廳、陜西省人力資源和社會(huì)保障廳、陜西省工商行政管理局批準(zhǔn)成立的保安服務(wù)有限公司,同時(shí)也是陜西省政府就業(yè)培訓(xùn)定點(diǎn)機(jī)構(gòu)。

是經(jīng)西安市公安局審查,陜西省公安廳、陜西省民政廳、陜西省人力資源和社會(huì)保障廳、陜西省工商行政管理局批準(zhǔn)成立的保安服務(wù)有限公司,同時(shí)也是陜西省政府就業(yè)培訓(xùn)定點(diǎn)機(jī)構(gòu)。

我們的優(yōu)勢(shì)和服務(wù) Personalized Success Plan

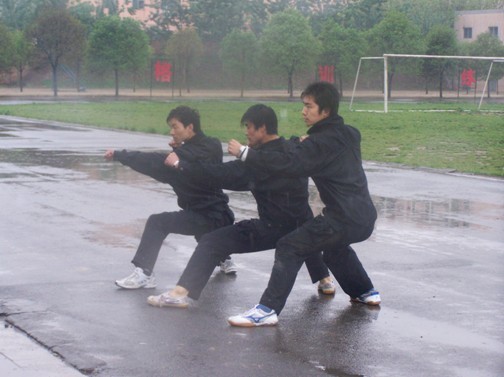

現(xiàn)代化的教學(xué)環(huán)境;目標(biāo)明確的教學(xué)宗旨和理念;

形式多樣又密切相關(guān)的教學(xué)活動(dòng);

強(qiáng)調(diào)能力培養(yǎng)與自我負(fù)責(zé)的教學(xué)手段;

學(xué)校注重學(xué)員綜合能力、實(shí)際動(dòng)手能力以及體能訓(xùn)練的培養(yǎng)。

經(jīng)典案例 Classic Case

派駐北京的女保安

派駐北京的女保安

大型活動(dòng)執(zhí)勤

大型活動(dòng)執(zhí)勤

銀行保安員指導(dǎo)客戶填單

銀行保安員指導(dǎo)客戶填單

派駐北京天安廣場(chǎng)保安正在執(zhí)勤

派駐北京天安廣場(chǎng)保安正在執(zhí)勤

西安大雁塔執(zhí)勤前動(dòng)員

西安大雁塔執(zhí)勤前動(dòng)員

大型演出執(zhí)勤

大型演出執(zhí)勤

大型演出執(zhí)勤

大型演出執(zhí)勤

西安市公安局出入境管理處保安執(zhí)勤

西安市公安局出入境管理處保安執(zhí)勤

西安市公安局門崗執(zhí)勤保安

西安市公安局門崗執(zhí)勤保安

西安市公安局門崗執(zhí)勤保安

西安市公安局門崗執(zhí)勤保安

新聞資訊 News & Information

2025年6月下旬,某企業(yè)人員軍訓(xùn)任務(wù)在我校圓滿落幕。此次軍訓(xùn)任務(wù)由我校精心組織并成功承接...

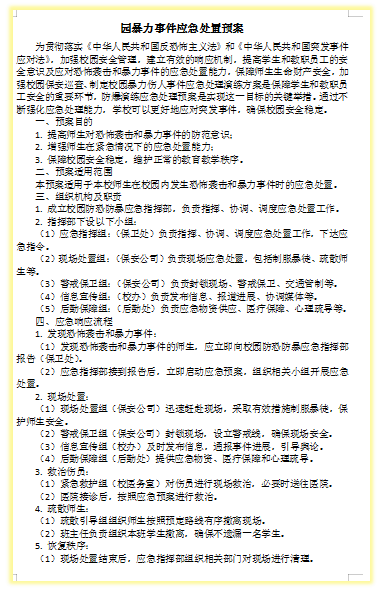

為應(yīng)對(duì)日益嚴(yán)峻的校園安全反恐防暴形勢(shì),不斷提高全體安保人員反恐防暴意識(shí),熟悉校園反恐防暴常...

新時(shí)代下,安保行業(yè)正在經(jīng)歷由傳統(tǒng)安保向智能安保的轉(zhuǎn)型。這一轉(zhuǎn)型主要是由于人工智能、物聯(lián)網(wǎng)(...

校園風(fēng)采 Campus Mien

十一年來油田礦區(qū)、巡邏車輛、巡護(hù)人員均安全無事故、無一例監(jiān)守自盜、內(nèi)外勾結(jié)、涉油事件的發(fā)生...

聯(lián)系我們 Contact Us

西安市長樂東路2999號(hào)

京都國際三號(hào)樓2606室

京都國際三號(hào)樓2606室

yuanjingbaoan@163.com

客服熱線:029-83563286 / 17782582796

Copyright ? 2019-2026 遠(yuǎn)景保安服務(wù)有限公司 版權(quán)所有 陜ICP備2023018003號(hào)-1

友情鏈接: 旭陽科技 百度 網(wǎng)易

友情鏈接: 旭陽科技 百度 網(wǎng)易